KI-Kurs Teil 3: Warum sind Daten für Machine Learning so wichtig?

Das Konzept von Machine Learning mag zunächst kompliziert erscheinen, aber denken Sie daran, wie ein/e Jurastudent:in das Recht lernt: durch das Studium von Gesetzen, Urteilen, Kommentaren und Fallbeispielen. Je mehr Fälle der/die Studierende studiert, desto besser versteht er/sie das Rechtssystem. In ähnlicher Weise funktioniert Machine Learning, und Daten sind die „Fälle“, die das System studiert. Lassen Sie uns dies genauer betrachten.

Daten: Die Grundbausteine von Machine Learning

- Daten als Lernmaterial: Genau wie ein Anwalt / eine Anwältin Gesetzbücher und Urteile studiert, „liest“ ein Machine Learning-Modell Daten. Die Daten sind die Grundlage, auf der es lernt und versteht, wie es eine bestimmte Aufgabe ausführen soll.

- Qualität und Quantität: Stellen Sie sich vor, Sie hätten nur Zugriff auf unvollständige oder fehlerhafte Gesetzbücher. Es wäre sehr schwierig, zuverlässige Schlussfolgerungen zu ziehen. Vergleichsweise benötigt ein Machine Learning-Modell genaue und umfangreiche Daten, um korrekt zu funktionieren.

- Relevanz der Daten: Wenn ein Anwalt / eine Anwältin Steuerrecht studieren möchte, sind Informationen über Strafrecht weniger relevant. Die Daten müssen auch im Machine Learnin für das Problem relevant sein, das das Modell zu lösen versucht.

- Daten als Spiegel der Realität: In der Rechtspraxis treffen sie Entscheidungen basierend auf den Fakten eines vergleichbaren Falles. Daten in Machine Learning dienen dem gleichen Zweck: Sie reflektieren die Realität und ermöglichen es dem Modell, Muster und Zusammenhänge zu erkennen.

Wie es in der Praxis funktioniert

- Trainingsdaten: Diese Daten sind wie die Lehrbücher und Fallstudien, die ein Jurastudent während des Studiums liest. Das Modell „studiert“ diese Daten, um die Grundlagen zu lernen.

- Testdaten: Stellen Sie sich diese Daten wie die Prüfungen in der Juristenausbildung vor. Das Modell wird anhand dieser Daten getestet, um zu sehen, wie gut es gelernt hat.

- Echtzeitdaten: Sobald ein Anwalt / eine Anwältin qualifiziert ist, arbeitet er/sie an realen Fällen. Ebenso verwendet ein Machine Learning-Modell (zusätzlich) Echtzeitdaten, um tatsächliche Aufgaben zu erfüllen.

Daten als Herzstück des Lernprozesses

Für Jurist:innen kann es hilfreich sein, Daten im Kontext von Machine Learning als äquivalent zu den Gesetzen, Urteilen und Fallstudien zu betrachten, die im Laufe der Karriere studiert und interpretiert werden. Ohne Daten gibt es nichts, woraus das Modell lernen kann. Die Qualität, Quantität und Relevanz der Daten bestimmen, wie effektiv und zuverlässig das Modell sein wird.

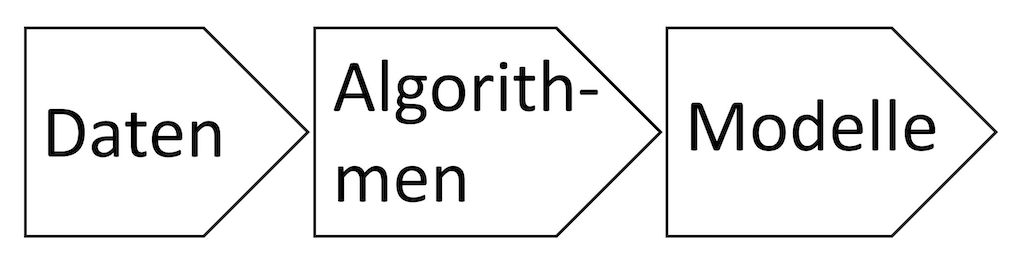

Einordnung der Wichtigkeit von Daten und Überblick über die Schritte beim Machine Learning

Machine Learning (ML) hat sich als ein zentraler Baustein in der Welt der Künstlichen Intelligenz (KI) etabliert. Für Jurist:innen und Rechtsberufe bietet es die Möglichkeit, große Mengen von Daten zu analysieren und zu interpretieren. Aber wie funktioniert es eigentlich? Dieser Abschnitt zielt darauf ab, das Konzept des ML übersichtshalber zu erläutern und den Prozess, wie es auf den juristischen Bereich angewendet werden kann, zu veranschaulichen.

Abschnitt 1: Daten in Machine Learning

Datensammlung: Im ML-Prozess sind Daten die Rohstoffe (s.o.). Diese könnten aus verschiedenen Quellen wie Gesetzestexten, Urteilen, Aktennotizen und mehr stammen.

- Datentypen: Die Daten können strukturiert oder unstrukturiert sein. Strukturierte Daten sind gut organisiert, während unstrukturierte Daten wie Textdokumente mehr Vorbereitung erfordern.

- Datenbereinigung: Ungenaue oder unvollständige Daten müssen bereinigt werden, um nützliche Informationen zu extrahieren.

- Datenaufteilung: Die Daten werden in Trainings- und Testsets aufgeteilt, um das Modell zu trainieren und seine Genauigkeit zu überprüfen.

Abschnitt 2: Algorithmen im Machine Learning

Algorithmenauswahl: Der ausgewählte Algorithmus definiert die Regeln, nach denen das Modell die Daten analysiert.

- Supervised Learning: Hierbei wird das Modell anhand von Beispieldaten trainiert, die bereits beschriftet sind, d.h. sie beinhalten Kennzeichen, was in den Daten zu finden ist.

- Unsupervised Learning: Im Gegensatz dazu versucht dieses Modell, Muster in den Daten ohne vorherige Beschriftung zu finden.

- Reinforcement Learning: Diese Methode basiert auf Belohnungen und Strafen, um das Modell zu lehren, wie es Entscheidungen treffen soll. „Zuckerbrot und Peitsche“ also für Maschinen. 😊

Abschnitt 3: Modelle im Machine Learning

Modellbildung: Die Modelle sind spezifische Implementierungen von Algorithmen, die auf Daten trainiert wurden.

- Training: Das Modell lernt von den Daten durch wiederholtes Anpassen und Optimieren.

- Validierung: Hier wird überprüft, wie gut das Modell auf neue, unbekannte Daten reagiert.

- Tuning: Dies bezieht sich auf die Feinabstimmung der Modellparameter, um die beste Leistung zu erzielen.

Validierung, Implementierung und Nutzung: Im Anschluss wird das Modell validiert d.h. Teile des Modells werden abgetrennt, um sie gegen die anderen Teile zu vergleichen. Dadurch kann das Modell getestet werden. Der andere Teil wird dann als Referenz verwendet. Sobald das Modell validiert ist, kann es in der realen Welt eingesetzt werden.

Auf die meisten der oben genannten Begriffe werden wir in weiteren Teilen dieses Kurses genauer eingehen.

Warum müssen wir das wissen?

Das Verständnis der Funktionsweise von Machine Learning und seiner Anwendung ist für Jurist:innen von großem Wert. Von der automatisierten Dokumentenklassifizierung bis zur Vorhersage von Gerichtsurteilen kann ML den Arbeitsfluss effizienter gestalten und zu besser informierten Entscheidungen führen. Der Schlüssel liegt in der Auswahl der richtigen Daten, Algorithmen und Methoden, die zu den spezifischen Anforderungen und Zielen passen. Nur wenn man das Zusammenspiel der verschiedenen Komponenten versteht, kann man später die richtigen Tools an den richtigen Stellen einsetzen.

Wie geht es weiter?

Um das „Bullshitting“ zu vermeiden, ist es wichtig einige Begriffe aus dem Bereich besser zu kennen. Wir gehen im nächsten Teil der Reihe darauf ein, wie Daten durch Tokenisierung aufbereitet werden und erklären einige wichtige Begriffe, damit ein solides Fundament für Diskussionen entsteht. Schreiben sie mir gerne, welche Begriffe sie besonders interessieren.

Autor: Stefan Schicker ist Rechtsanwalt und Partner bei SKW Schwarz sowie Innovationsberater mit speziellem Fokus auf KI und Mindset-Wandel.